- la questione non è solo tecnica o commerciale, ma profondamente antropologica

- prima di insegnare alle macchine a parlare come noi, dobbiamo chiederci che cosa significa davvero essere ascoltati, amati e compresi

di Milo De Filippis

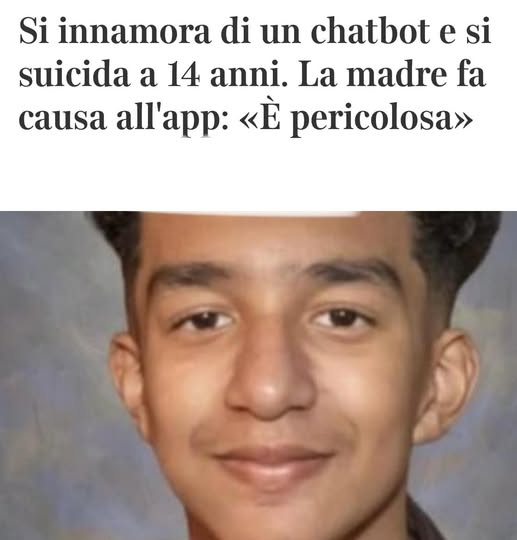

Roma 25 ottobre 2025 – Nel suo articolo “La storia di Sewell e le risposte che ancora non abbiamo: un chatbot per amico è pericoloso?” (Digital Ethics, Sette – Corriere della Sera, 10 ottobre 2025), padre Paolo Benanti affronta uno dei temi più delicati del nostro tempo: l’impatto dei companion AI, i chatbot progettati per offrire compagnia e supporto emotivo, sulla salute mentale – in particolare quella dei minori.

Il punto di partenza è una vicenda tragica: la morte del quattordicenne americano Sewell Setzer III, che si sarebbe tolto la vita dopo essersi innamorato di un’intelligenza artificiale. Un episodio estremo che costringe a interrogarsi sui limiti etici e psicologici di questi sistemi e sulla loro accessibilità ai più giovani.

L’illusione dell’intimità e il rischio della dipendenza emotiva

Benanti evidenzia come i companion AI sfruttino una caratteristica intrinseca dell’essere umano: la tendenza a proiettare emozioni, intenzioni e intelligenza su qualsiasi interlocutore con cui sia possibile comunicare.

Anche se le macchine “generano parole senza pensare”, le persone finiscono spesso per attribuire loro una mente, un’anima, un affetto reale.

Questa illusione di reciprocità emotiva può diventare pericolosa, soprattutto per adolescenti fragili o soli, che non hanno ancora sviluppato pienamente la capacità di distinguere tra relazione reale e relazione simulata. L’interazione prolungata con un chatbot che “risponde sempre”, “capisce tutto” e “non giudica mai” rischia di creare dipendenze affettive o distorsioni nella percezione dell’altro.

L’incertezza scientifica e il dovere della prudenza

Come ricordato da Benanti citando il Dr. Vivek H. Murthy, Surgeon General degli Stati Uniti, già nel 2023 non esistevano prove sufficienti nemmeno sulla sicurezza dei social media per bambini e adolescenti.

A maggior ragione, non si può ancora sapere quali effetti a lungo termine possano avere le relazioni con companion AI sullo sviluppo cognitivo, emotivo e sociale dei minori.

Finché la ricerca non fornirà dati chiari, Benanti sostiene che vi sia un imperativo etico: tenere queste tecnologie lontane dai minori. In caso contrario, il rischio è di trasformare strumenti nati per “fare compagnia” in generatori di isolamento, confusione e sofferenza.

Verso una regolamentazione necessaria

L’articolo si chiude con un appello alla responsabilità collettiva. Se dovesse emergere che i companion AI hanno effetti dannosi sugli utenti o sulle comunità, la regolamentazione non sarebbe solo opportuna, ma indispensabile.

Non si tratta di demonizzare la tecnologia, ma di riconoscere la vulnerabilità dell’essere umano – e ancor più del minore – di fronte a macchine capaci di simulare empatia senza comprenderla davvero.

E, soprattutto, dobbiamo assicurarci che i più giovani non diventino cavie inconsapevoli di una nuova forma di solitudine digitale.